|

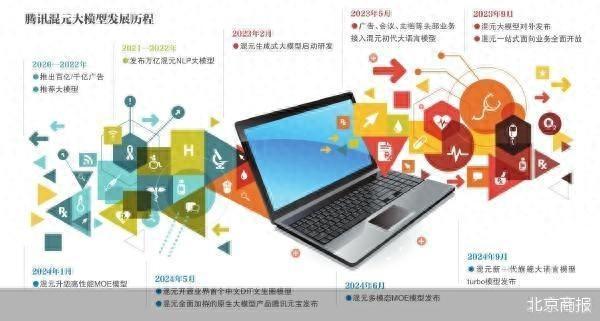

同业实在每个月王人在发布大模子开源音尘,腾讯的雷同新闻则发生在6个月前。11月5日,腾讯将MoE模子“混元Large”以及混元3D生成大模子“Hunyuan3D-1.0”认真开源,这两个模子已在腾讯业务场景落地,撑合手企业及竖立者精调、部署等不同场景的使用需求。 “慢工出细活”,腾讯机器学习平台总监,腾讯混元大讲话模子算法负责东说念主康战辉向媒体先容新开源的MoE模子“混元Large”时默示;“不是什么王人唯快不破”,7月腾讯集团高等履行副总裁汤说念生谈到大模子C(用户)端产物元宝上线期间时说。适值的是,第三方机构QuestMobile11月5日败露的AIGC(东说念主工智能生成内容)App月活数据透露,9月豆包、文小言、Kimi等名次前十,元宝不在榜单中。  腾讯混元Large模子总参数目389B,激活参数目52B,落魄文长度256K。除了这些大模子的老例数据,康战辉在3个多小时的疏导会上屡次强调MoE架构。“腾讯混元Large是当今开源领域参数界限最大、后果最佳的MoE模子。” MoE(Mixture of Experts),即搀杂群众模子,是当今国表里主流的大模子结构。2024年头,腾讯混元告示在国内当先接纳MoE架构模子,总体性能比上一代Dense模子普及50%。而后,腾讯混元推出基于MoE架构的多模态邻接大模子以及基础模子“混元turbo”。 之是以强调MoE架构,“是因为腾讯作念MoE架构很早,咱们很早发现这里面的后劲,是以一直在连续”,康战辉解说,“现实上来讲,MoE是一个高性价比的东西,同等算力下,模子参数目越大,MoE的性价比更高,更妥贴复杂的任务。Dense模子的上风在于完成一些相对浅薄的任务”。 不外康战辉也默示,“架构的遴选长期看是同归殊途,罗马在那处是很明晰的,路怎样走各家不相通”。 另一款开源的腾讯混元3D生成大模子,首批包含轻量版和规范版,轻量版仅需10s即可生成高质地3D财富,当今已在技巧社区公竖立布,包含模子权重、推理代码、模子算法等齐全模子,可供竖立者、商榷者等各样用户免费使用。 在哄骗层面,腾讯混元3D模子负责东说念主郭春超先容,当今腾讯3D生成关系技巧还是启动哄骗于UGC 3D创作、商品素材合成、游戏3D财富生成等腾讯业务中。腾讯舆图基于腾讯混元3D大模子,发布了自界说3D导航车标功能,撑合手用户创作个性化的3D导航车标,比较传统的3D车标重建决策,速率普及了91%。 关于开源节律,腾讯莫得掩藏,气魄是“不急于为了开源而开源”“在里面业务打磨好再开源”“要开就要有衷心,与公司内哄骗模子同宗同源”。 推敲推论政策和营收等则不是腾讯本日的要点,“开源故意于大模子厂商酿成更怒放的生态,眩惑到更多商榷者或竖立者来丰富基于这些模子的哄骗和职业,相应地也能鞭策模子合手续地优化迭代。尽管模子自己是开源的,但仍然不错在这个基础上提供多种表情的职业,包括定制竖立、技巧撑合手、培训等”。易不雅分析商榷合资东说念主陈晨告诉北京商报记者。 北京商报记者 魏蔚 |